ōmega #1 / L'insostenibile peso dei superchip

Quanto consuma produrre i chip con cui si addestrano le AI?

Benvenuti alla newsletter #1 di ōmega, un progetto a cura di Roberto Pizzato e Cesare Alemanni. Raccontiamo l’intelligenza artificiale e i suoi riflessi sulla società.

Cominciamo con un articolo di Cesare Alemanni, che racconta il crescente consumo di energia e di risorse connesso all’infrastruttura della computazione su cui si basano i modelli di addestramento delle intelligenze artificiali.

Vi ricordiamo che se non siete ancora iscritti alla newsletter potete farlo subito, basta inserire la vostra mail nel box qui di seguito.

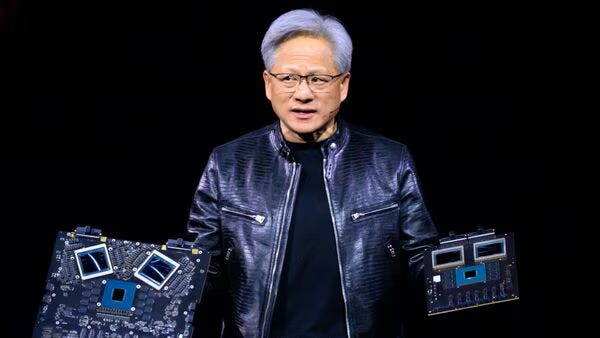

Lo scorso 18 marzo migliaia di persone hanno preso d’assalto un’arena di San Jose per assistere a uno spettacolo. Non si trattava, tuttavia, di un concerto o di un evento sportivo bensì della presentazione di un chip. Con la sua ormai iconica giacca di pelle nera, a condurre lo show c’era la cosa più simile a una rockstar nell’industria tecnologica mondiale: Jensen Huang, CEO e fondatore di Nvidia, un’azienda con una capitalizzazione di quasi 2 trilioni di dollari, la terza più “ricca” del mondo dietro a Microsoft e Apple

Fino al 2020, il market cap di Nvidia non era neppure un decimo di quello attuale. L’esplosione si deve al fatto che i chip di Nvidia sono una componente fondamentale dell’infrastruttura della computazione alla base dello sviluppo di innumerevoli modelli di intelligenza artificiale, inclusi quelli generativi.

Come racconto ne Il piccolo re – il mio libro sulla storia, l’evoluzione e la geopolitica dei chip in uscita a maggio per Luiss University Press – da trent’anni Nvidia progetta (la manifattura è svolta altrove) le ormai celeberrime GPU (Graphic Processing Unit), ovvero microprocessori in grado di svolgere più computazioni specializzate in parallelo (parallel computing) rispetto alle più “tradizionali” CPU. Utilizzate fin dagli anni Novanta soprattutto per calcolare le grafiche 3D dei videogiochi, grazie alla loro abilità nel parallel computing negli anni Dieci le GPU si sono rivelate un potente strumento per addestrare modelli AI.

Nvidia è oggi leader del settore delle GPU anche grazie alla sua capacità di affiancare alla potenza di calcolo di questi processori, uno strumento, noto come CUDA, che rende la loro programmazione più semplice e veloce. Grazie a queste tecnologie oggi Nvidia copre circa l’80% del mercato dei chip AI.

Quella di Huang è dunque l’azienda a cui tutti guardano per anticipare il futuro del settore. Si spiega così l’attenzione per l’evento di San José. In quell’occasione Nvidia presentava Blackwell, un superchip da 208 miliardi di transistor che è, al momento, la GPU più avanzata al mondo: 30 volte più veloce dei suoi predecessori.

Nvidia ha investito circa $10 miliardi per il suo sviluppo e ogni esemplare di Blackwell costerà tra i 30 e i 40mila dollari.

Durante l’evento di San Jose l’annuncio di Blackwell è stato accolto da un tripudio, simile a quelli che nei primi Duemila accompagnavano le presentazioni di Steve Jobs di nuovi prodotti Apple.

Secondo gli esperti, alcune caratteristiche di Blackwell promettono di rendere possibile addestrare grandi modelli AI con una minora impronta di carbonio. Huang ha sottolineato più volte questo punto, ricordando come il futuro dell’AI dipenda dal riuscire a “consumare sempre più calcolo rimanendo sostenibile”.

Ricercatori di OpenAI (quando era ancora una non-profit) hanno calcolato che da quando si sono accesi i motori dell’industria dell’intelligenza artificiale, la quantità di computazione destinata allo sviluppo di AI è raddoppiata in media ogni tre mesi, cioè quasi decuplicata ogni anno, un esponenziale impressionante. Un recente studio dell’Università del Massachusetts ha invece calcola to che l’addestramento di un singolo modello AI produce una massa di diossido di carbonio equivalente all’incirca a 300 viaggi aerei tra Milano e Tokyo.

Proseguendo con l’attuale andamento, il consumo di elettricità destinato all’addestramento di modelli AI rischia di raddoppiare entro il 2030, arrivando, in alcuni paesi particolarmente densi di data center, a picchi pari al 30% del totale, un carico del tutto insostenibile per le reti. Sono dunque benvenuti strumenti capaci di garantire, in proporzione, più potenza di calcolo ma con una maggiore efficienza energetica.

L’avvento di chip con un miglior rapporto potenza/consumo è sicuramente un passo nella giusta direzione. Tuttavia, come racconto nel terzo capitolo del mio libro, ciò che, in occasione di annunci come quello di Blackwell, si tende a sottovalutare è che non solo l’utilizzo dei superchip per l’AI ha un notevole impatto energetico e ambientale ma ce lo ha anche la loro produzione.

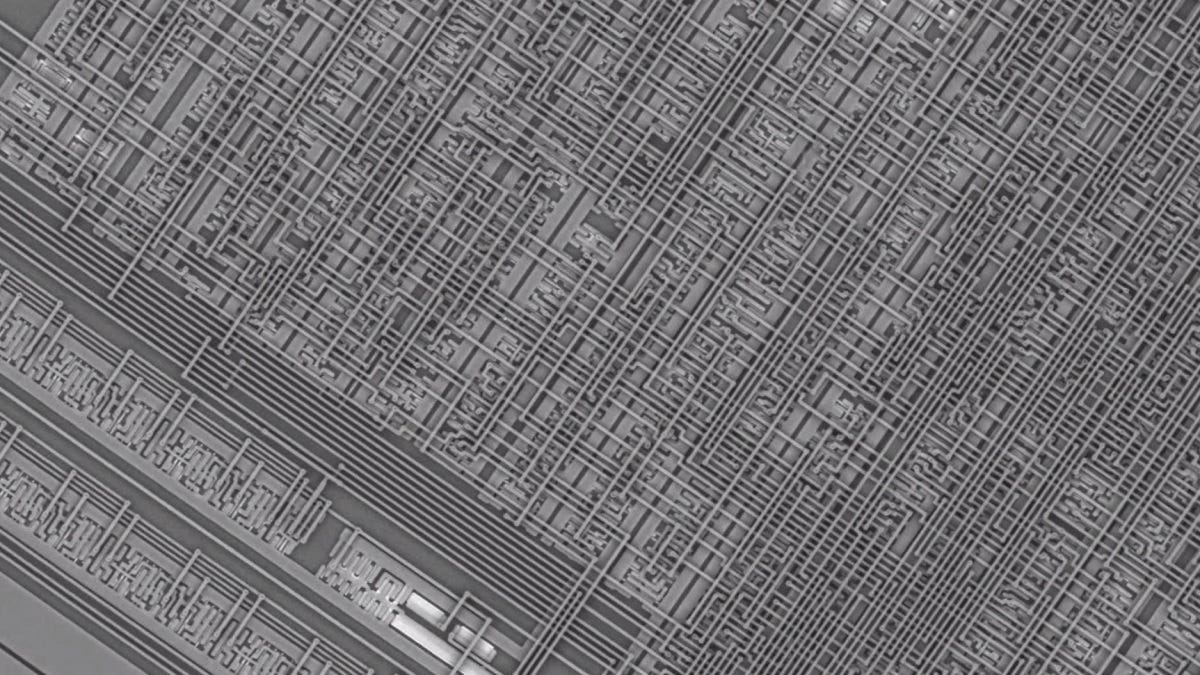

Pressoché ogni aumento di “pura” potenza dei chip si basa essenzialmente su un aumento della densità e del numero dei transistor che essi contengono. Tale aumento si ottiene – è una questione piuttosto intuitiva – attraverso una costante diminuzione delle dimensioni dei transistor contenuti nei chip. Oggi siamo arrivati al punto in cui un chip di ultima generazione può contenere componenti grandi meno di 5 nanometri (di seguito: nm), ovvero molto ma molto più piccoli di un virus, 100mila volte più piccoli del diametro di un capello.

Come nel caso di Blackwell, questa riduzione delle dimensioni dei transistor tendenzialmente permette in effetti ai sistemi di computazione (inclusa la filiera dell’AI) di lavorare in un regime di maggiore efficienza.

Il problema é che più la frontiera della miniaturizzazione avanza e maggiore è l’impatto energetico dei sistemi di manifattura dei chip. Si calcola che produrre un chip al “nodo” dei 2 nm (nodo è un termine industriale che indica il livello di sviluppo dei processi di manifattura dei chip), consumi più del doppio dell’acqua e tre volte tanta elettricità rispetto ai chip al nodo dei 28 nanometri che erano considerati avanguardia nemmeno dieci anni fa.

Ogni step nella produzione di chip più piccoli richiede un’energia esponenzialmente maggiore rispetto al passato. Prendiamo, per esempio, la stampa litografica che utilizza la tecnologia dell’ultravioletto estremo (Euv) con cui oggi si stampano i circuiti più avanzati. Essa ha sì il vantaggio di ridurre il numero di passaggi necessari alla “stampa” dei chip ma, al contempo, il suo consumo di energia per singolo chip risulta quasi decuplicato. Il risultato è che una fabbrica che produce chip avanzati oggi consuma 100 megawattora in un’ora, ovvero quanto 80mila abitazioni di medie dimensioni.

A ciò bisogna aggiungere il fatto che la produzione di un chip è un processo che, dall’inizio alla fine, coinvolge, tra l’altro, l’estrazione, la purificazione e la manipolazione di numerosi materiali (silicio, terre rare, germanio e numerosi altri) coinvolgendo gas, acidi, solventi e altre sostanze altamente tossiche ed inquinanti, il cui consumo, tendenzialmente, aumenta con l’aumentare della complessità tecnologica dei chip (chip più potenti tendenzialmente richiedono, per esempio, silicio a livelli di purezza più elevati del normale).

Esiste dunque, molto concretamente, il rischio di infilarsi in un circolo vizioso per cui l’aumento di efficienza energetica dei chip destinati all’AI viene sì in effetti ottenuto, e molto pubblicizzato, ma solo attraverso un equivalente, e meno discusso, aumento dell’impatto energetico e ambientale dei sistemi di manifattura di quegli stessi chip.

Oggi vi presentiamo Hype, la rubrica dove, senza prenderci del tutto sul serio, segnaliamo e scherziamo in merito a storie, notizie, trend, curiosità ed eccessi nel meraviglioso mondo delle intelligenze artificiali.

La prima puntata la vogliamo dedicare a un curioso fenomeno YouTube che abbiamo deciso di ribattezzare “countries as”.

Da qualche tempo, ogni volta che entriamo su YouTube l’algoritmo ci presenta contenuti provenienti dalla pagina Planet AI.

La pagina propone reel composti da decine di immagini chiaramente realizzate con un’intelligenza artificiale generativa (probabilmente MidJourney). La peculiarità dei reel è che sono tutti basati su alcuni format. Uno dei più ricorrenti è appunto “countries as..”, ovvero “paesi come se fossero…”.

E allora ecco “paesi come se fossero guerrieri”, “paesi come se fossero mostri del cinema”, “paesi come se fossero cavalieri medievali” e poi, ancora, “cattivi dei film”, “personaggi dei manga”, “demoni”, “Transformers” e chi più ne ha più ne metta, ce ne sono davvero tantissimi (e non è l’unico format, ci sono per esempio anche altri filoni, seppure meno popolari, tipo “mesi come”, “nomi come”, “stagioni come” e forse il più strano di tutti: “nomi utenti come cattivi degli anime”).

L’intento evidentemente è quello di sfruttare la curiosità per l’AI, un po’ di campanilismo e la popolarità di alcuni specifici immaginari della cultura pop per creare, con uno sforzo molto relativo, contenuti “virali” e dunque remunerativi (riuscendoci anche piuttosto bene, a giudicare dai numeri di views del canale). Dopotutto: è la “contentizzazione” bellezza!

E se osservare come l’AI declina gli stereotipi sui singoli paesi nelle varie categorie d’immaginario su cui gli viene richiesto di lavorare può essere, o sembrare, interessante, il problema, come raccontato anche nell’articolo principale di questo primo numero di ōmega, è che la realizzazione di ognuna di queste migliaia e migliaia di immagini ha in realtà un prezzo, non trascurabile, in termini energetici e ambientali.

Vi ricordiamo che ōmega è anche un podcast, con frequenza mensile, di interviste a esperti o personalità che studiano, raccontando, analizzano o sviluppano intelligenze artificiali. Lo potete ascoltare su Spotify qui: